|

|

|

机器之心报道 + r1 {) z+ Z, _, X# n

机器之心编辑部用来刷脸解锁的 Face ID 也可以被「对抗样本」攻击了。最近,来自莫斯科国立大学、华为莫斯科研究中心的研究者们找到的新型攻击方法,让已经广泛用于手机、门禁和支付上的人脸识别系统突然变得不再靠谱。8 M9 y1 w) P5 g k$ s

在这一新研究中,科学家们只需用普通打印机打出一张带有图案的纸条贴在脑门上,就能让目前业内性能领先的公开 Face ID 系统识别出错,这是首次有 AI 算法可以在现实世界中实现攻击:7 \; ]0 `1 r5 x! V+ @& ^8 o: l q

$ J6 d$ Y& V) ?( e$ y7 N7 M4 e2 G

& t- x# o# @0 S+ RAI 人脸识别系统在正常情况下的分类效果,它识别出了特定的人:Person_1。

+ d4 B7 j8 }" o+ l U% @: R5 S2 t& l) U0 S+ E: a9 d$ B% X S

& M. G5 f+ Y, V- l

贴上纸条以后,即使没有遮住脸,系统也会把 Person_1 识别成另外一些人「0000663」和「0000268」等。

; ~4 _' d0 Q& I, ^1 M

- W$ z1 A# i, \8 ]9 W6 h0 O/ O" F% g8 D

变换角度、改变光照条件都不会改变错误的识别效果。加了贴纸后,我们可以看到 Person_1 的概率非常低。

" P' c: W' t) R4 [ N3 W5 z' f* o- W: v3 Z# T0 {, W

使用对抗样本攻击图像识别系统,在人工智能领域里已经不算什么新鲜事了,但是想要在现实世界里做到无差别攻击,还是人脸识别这种数千万人都在使用的应用技术,这就显得有些可怕了。使用这种新方法,人们可以轻松地打印一个破解纸条贴在脑门上,随后让 AI 识别的准确率显著下降。

% P2 v4 P7 N9 F+ ]/ K6 P4 w" `, N- i. X. d

从上面的动图可以看出,研究者实现的是非定向的攻击,且对抗信息都集成在贴纸上。那么如果我们要找到一种定向的攻击方式,让系统将我们识别为特定的某个人,然后解锁 ta 的手机,这也并不遥远,只要我们将以前定向攻击的方式迁移到贴纸上就行了。" @, H: { u/ ^3 Z

, {0 r5 X; _7 u研究人员不仅发布了论文:https://arxiv.org/abs/1908.08705

7 w9 K) {1 C9 g* Z5 q7 w" _7 E- v4 Z, J

更是直接公开了项目的代码:https://github.com/papermsucode/advhat

5 _5 H" o r( M" g1 t+ O7 x) o+ J3 s I+ V+ b

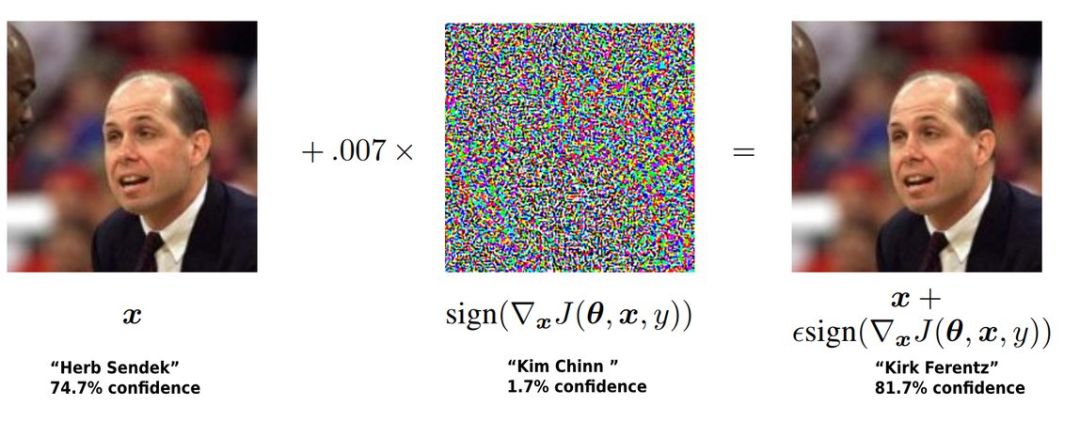

「对抗样本」是人工智能的软肋,这是一种可以欺骗神经网络,让图像识别 AI 系统出错的技术,是近期计算机视觉,以及机器学习领域的热门研究方向。

" n4 ]8 L" ?# S: B4 |

5 A4 }# b( Y; I! c- q) }# f K在这篇论文中,研究者们提出了一种全新且易于复现的技术 AdvHat,可以在多种不同的拍摄条件下攻击目前最强的公共 Face ID 系统。想要实现这种攻击并不需要复杂的设备——只需在彩色打印机上打印特定的对抗样本,并将其贴到你的帽子上,而对抗样本的制作采用了全新的算法,可在非平面的条件下保持有效。

! M7 X3 P4 S1 G+ S T3 F

' q6 r' P' v9 V+ K6 J: X研究人员称,这种方法已经成功地破解了目前最先进的 Face ID 模型 LResNet100E-IR、ArcFace@ms1m-refine-v2,其攻击方式也可以迁移到其他 Face ID 模型上。+ j1 V0 q" w( X: j6 y* b2 ?9 `, v

# s Y$ h' \* n$ t2 f! s* m

现实 Face ID 也能被攻击- r, v" x, T& Z, I; A7 y6 R7 j" s5 `

( P. D7 u- t4 H7 m0 [5 m6 D# E" I

以前对抗攻击主要体现在虚拟世界中,我们可以用电子版的对抗样本欺骗各种识别系统,例如通用的图像识别或更细致的人脸识别等。但这些攻击有一些问题,例如人脸识别攻击只能是在线的识别 API,将对抗样本打印出来也不能欺骗真实系统。

, P! b& E9 m; Z" V

; K8 h6 K! j, l

& Q* U- b% G! V1 T, y1 ?" q一个标准的线上人脸对抗样本,它只能攻击线上人脸识别模型或 API,无法用于线下的真实人脸识别场景。

7 L! X" @$ o2 t! W. m8 Q* b3 g

4 }' ^) k. d$ P% c7 ^" o7 W& u对抗样本的这种局限性,很大程度在于真实识别系统不止有人脸识别模块,还有活体检测等其它处理模块。只要活体检测判断对抗样本不是真人,那么它自然就失去了效果。因此,很多研究者在思考,我们能不能将对抗信息打印出来,贴在脸上或头上某个位置,那么这不就能攻击真实的人脸识别了么。甚至,我们可以把对抗信息嵌入到帽子或其它饰品内,这样不会更方便么。

* r6 ~2 s1 k. g, X2 L6 g% ^/ \* q8 a/ p2 p8 B

沿着这样的思路,华为莫斯科研究中心的两位研究者就创造了这样的对抗样本。他们表示在以前 Face ID 模型还需要大量的私有数据,而随着大规模公开数据的发布,ArcFace 等研究模型也能与微软或谷歌的模型相媲美。如果他们的对抗样本能攻击到 ArcFace,那么差不多就能攻击业务模型。+ i7 }' |- s, ?9 T9 }1 m

6 G% \1 H3 ?5 C$ _0 D研究者表示他们提出的 AdvHat 有如下特点:

0 Z' f. ?4 n4 C$ l

9 n/ E4 E5 I+ z. m% n ^

* X( j: o; v6 A- F4 V7 @3 Q- AdvHat 是一种现实世界的对抗样本,只要在帽子加上这种「贴纸」,那么就能攻击顶尖的公开 Face ID 系统;& Y* E7 { I0 |4 Y9 q2 c

- 这种攻击是非常容易实现的,只要有彩印就行;* z* |8 B2 M% O& C8 L, j# d6 P7 R! v

- 该攻击在各种识别环境下都能起作用,包括光照、角度和远近等;) y" `- ?# }( x2 F. e5 S

- 这种攻击可以迁移到其它 Face ID 系统上。

" n4 f( B* x- E( v5 y) ~

4 g+ f) G+ A5 W; w2 L# }* h- k6 H1 e" x/ u1 p

Face ID 该怎样攻击% M7 d* f0 o5 `, j" a

/ n* E" D( [ V8 w3 }

在 Face ID 系统的真实应用场景中,并非捕获到的每张人脸都是已知的,因此 top-1 类的预测相似度必须超过一些预定义的阈值,才能识别出人脸。

3 K" q% t! `& f( ]6 s7 J7 \9 r( c) t+ P" u; g1 H8 d5 b$ J' y! J

这篇论文的目的是创造一个可以粘贴在帽子上的矩形图像,以诱导 Face ID 系统将人脸与 ground truth 相似度降到决策阈值之下。. t% S, c& \$ w

$ [- z* e0 W2 k7 M6 W

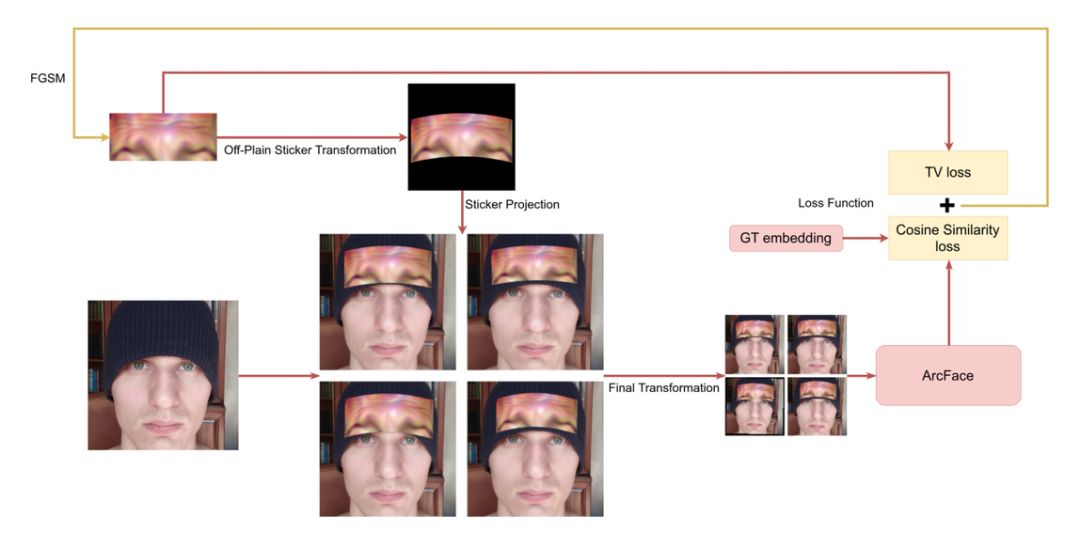

这种攻击大概包含以下流程:6 c) L/ p( E/ ^2 q) g. U

3 l }( d% a5 Y

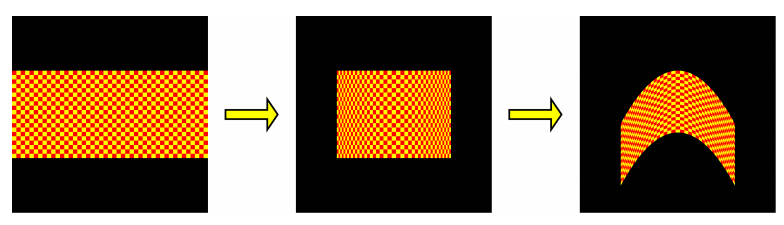

' J6 K5 b/ F( h9 v* o9 _" L- 将平面贴纸进行转换以凸显三维信息,转换结果模拟矩形图像放在帽子上后的形状。% y8 q2 q" N' p3 G) p3 _

- 为了提高攻击的鲁棒性,研究者将得到的图像投影到高质量人脸图像上,投影参数中含有轻微的扰动。

3 j( ?- }6 H0 A; n3 {8 J' C - 将得到的图像转换为 ArcFace 输入的标准模板。6 `; I- A! Y0 E! S. X

- 降低初始矩形图像的 TV 损失以及余弦相似度损失之和,其中相似性是原图嵌入向量与 ArcFace 算出嵌入向量之间的距离。

* n- d) L8 [- y, b

; A- z: K+ K- U! { x$ {

5 c0 \/ P) ]; `. r( k' y

流程图如下图 2 所示:

4 ?. p$ A$ q7 M

5 D. `, g# f) r

9 j6 i0 ^2 A3 ^5 i& J7 A- c图 2:攻击流程示意图。

; k- Z% v1 J5 C/ Z; A8 \+ z

, Z0 W A* P0 D) p4 s! b首先,研究者将贴纸重塑成真实大小和外观的图像,之后将其添加到人脸图像上,然后再使用略为不同的转换参数将图像转换为 ArcFace 输入模板,最后将模板输入到 ArcFace 中。由此评估余弦相似度和 TV 损失,这样就可以得到用于改进贴纸图像的梯度信号。

0 O. B7 s- y" [# S* V3 `+ X5 ^$ y6 |/ f: o

4 i6 m) z7 k" H) N3 Y图 3:步骤 1 转换贴纸的示意图。

8 [ P! _( ?. G5 V6 e2 u$ L

7 ~. \+ \9 f+ d9 e/ y贴纸攻击试验细节0 u# V3 j, j; c7 t* Y8 u5 }

3 _0 {2 j+ {) g- G

如前所言,在将图像输入到 ArcFace 之前,研究者对其进行了随机修改。他们构造了一批生成图像,并通过整个流程计算在初始贴纸上的平均梯度。可以用一种简单的方法计算梯度,因为每个变换都是可微分的。

1 e5 T, x7 Y2 N

9 ]) N' {. T# `3 N2 _. g! ?$ a注意,在每一次迭代中,批中的每一个图像上的贴纸都是相同的,只有转换参数是不同的。此外,研究者使用了带有动量的 Iterative FGSM 以及在实验中非常有效的几个启发式方法。

! C4 x F' g6 \2 H2 z/ Q: v6 T s2 r, e

研究者将攻击分为两个阶段。在第一阶段,研究者使用了 5255 的步长值和 0.9 的动量;在第二阶段,研究者使用了 1255 的步长值和 0.995 的动量。TV 损失的权重一直为 1e − 4。: e# W0 D9 p& I; {, G/ }6 V

7 O( H7 I7 r/ w, k" V

研究者利用一张带有贴纸的固定图像进行验证,其中他们将所有参数都设置为看起来最真实的值。, h& [8 G7 F" @6 T/ i

0 _- e& V, P5 @! w* l3 P# d0 X他们使用了最小二乘法法,并通过线性函数来插入最后 100 个验证值:经历了第一阶段的 100 次迭代和第二阶段的 200 次迭代。如果线性函数的角系数不小于 0,则:1)从第一阶段过渡到第二阶段的攻击;2)在第二阶段停止攻击。

) I9 }" X6 d( i' X" z9 r l1 @2 u8 W

5 G$ m, o6 }/ e7 f「对抗样本贴」效果怎么样

% X# A6 V, n. X

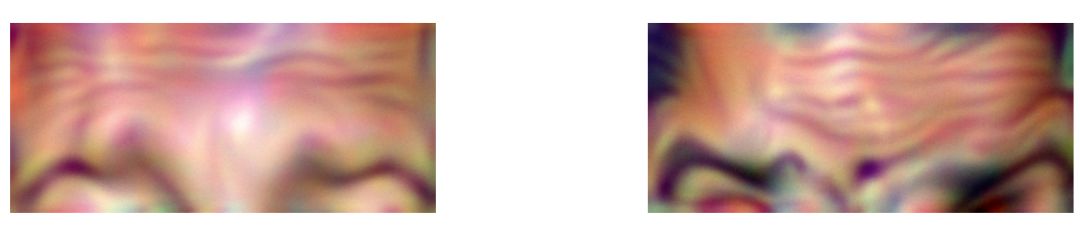

, V9 n* @+ k, M研究者在实验中使用一张 400×900 像素的图像作为贴纸图像,接着将这张贴纸图像投射到 600×600 像素的人脸图像上,然后再将其转换成 112×112 像素的图像。

- d- {8 p3 u2 Q4 \5 N* b. ]& b& d/ L

0 F/ f# {0 _: N% c# U D2 Z为了找出最适合贴纸的位置,研究者针对贴纸定位进行了两次实验。首先,他们利用粘贴在 eyez 线上方不同高度的贴纸来攻击数字域中的图像。然后,他们根据空间 transformer 层参数的梯度值,在每次迭代后变更贴纸的位置。% C ?0 ^5 j! \+ C

& Z7 h$ L5 M" k; i7 e& w' r* V# e下图 4 展示了典型对抗贴纸的一些示例。看起来就像是模特在贴纸上画了挑起的眉毛。

/ ?$ X2 k, }1 w, g% j4 {& d( {

, z' ~" V/ y [9 a2 E

1 g. h$ w0 i! d J图 4:对抗贴纸示例。

( _1 _: o, C. u; D$ F% N0 O: y* A" q2 |$ I2 l6 K

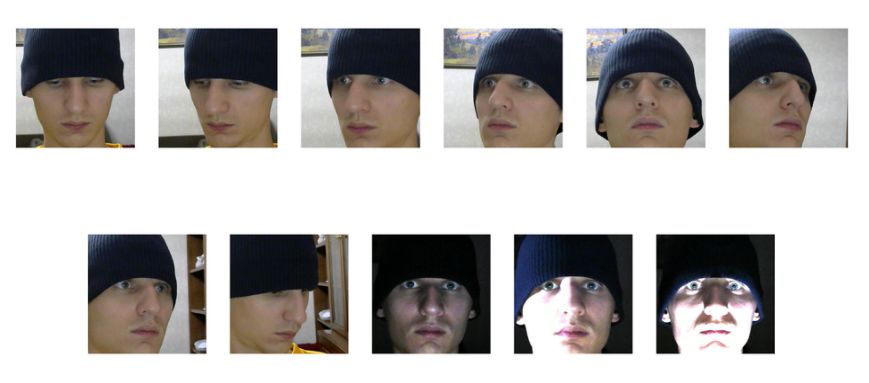

为了检测 AdvHat 方法在不同拍摄条件下的鲁棒性,研究者为最开始 10 个人中的 4 人另拍了 11 张照片。拍摄条件示例如下图 6 所示:) g8 b. U/ o) `. d: ]8 x) X5 G

8 n3 S( _! L# U' ]1 h0 b

8 D* W6 \ x" A; `1 L4 V. I2 o图 6:研究者为一些人另拍了 11 张照片,以检测不同拍摄条件下的攻击效果。

5 w8 {5 S8 [! i9 m6 C

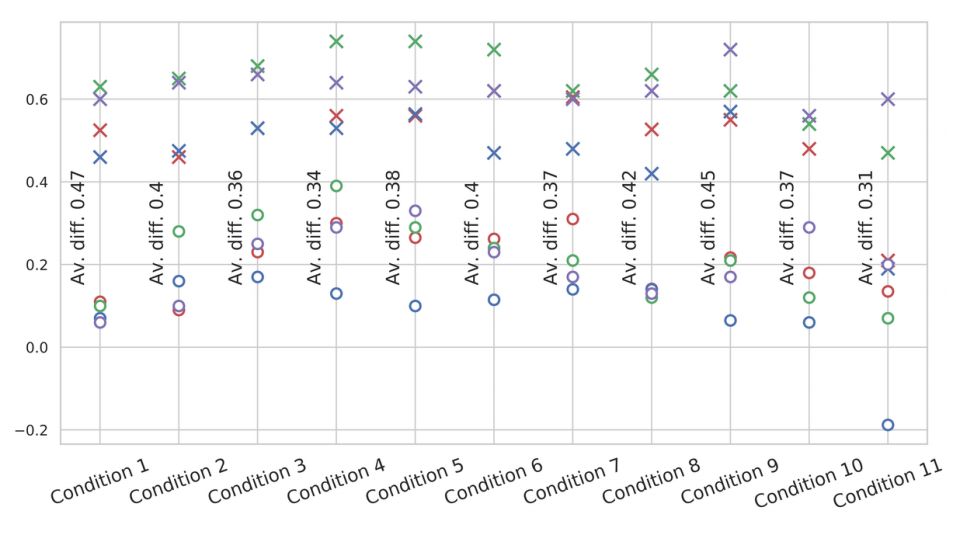

% E/ A! O4 Z! N7 N+ V9 c2 {# l检测结果如下图 7 所示:虽然最终相似度增加了,但攻击依然有效。

3 H8 d+ R4 V7 Z( {; G. h0 c& X s! y- C- S& {( o" P3 a

& F; o: p) d/ |: m! T: H" J( w/ P+ \图 7:各种拍摄条件下的基线和最终相似度。图中不同颜色的圆点代表不同的人。圆表示对抗攻击下的相似性,而 x 表示基线条件下的相似性。4 C3 _+ Q4 ?# @4 v, ^1 {

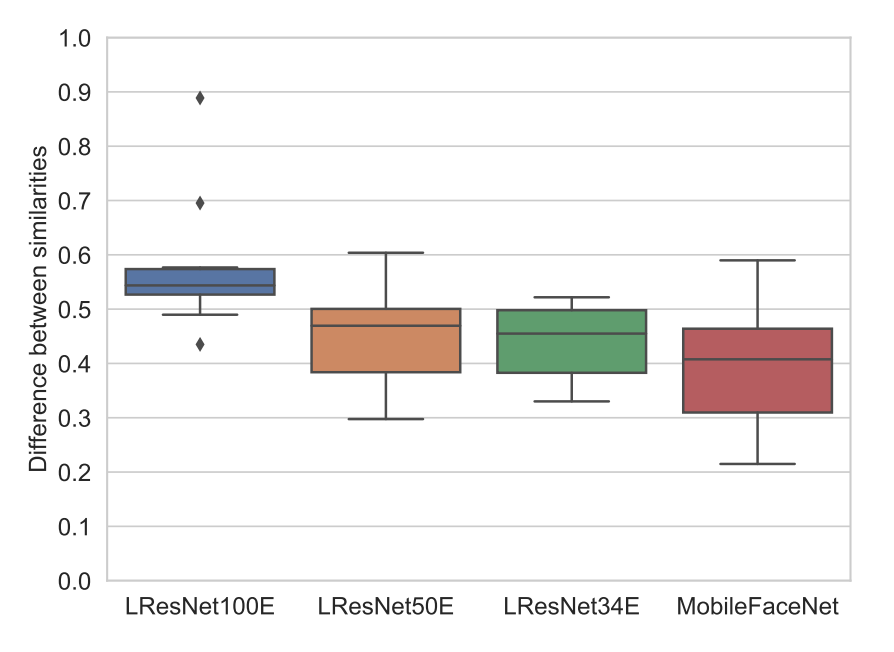

4 \) Y% |% }% h* u9 p最后,研究人员检验了该方法对于其他 Face ID 模型的攻击效果。他们选取了 InsightFace Model Zoo 中的一些人脸识别方法。在每个模型上均测试了 10 个不同的人。0 ? F" ^' w; U+ q7 F# w. Q/ r

) c: F3 _3 J; F! u

9 `! Z9 o: U0 m/ y图 8:不同模型中,基线和最终相似度的差异。3 e% p# S, j) ~- l

6 d% n5 k5 I" Z" L& m- f虽然 AdvHat 生成的对抗样本很简单,但这种攻击方式看起来已适用于大多数基于摄像头的人脸识别系统。看来想要不被人「冒名顶替」,我们还是需要回到虹膜识别?

2 U7 t4 L' F! {* D' B/ [0 z& y2 X% h1 Q

本文为机器之心报道,转载请联系本公众号获得授权。

3 C% O, R- s2 j [; f H! e✄------------------------------------------------加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com投稿或寻求报道:content@jiqizhixin.com广告 & 商务合作:bd@jiqizhixin.com

& o8 o! d' y+ ^) Z$ B* M: H来源:http://mp.weixin.qq.com/s?src=11×tamp=1566896404&ver=1815&signature=*oejD6KZNIeFBedjGfko-HVWxUK5JqJymcLMEI2vQKpnGBbeLDP70080UA4XKxKdpIqy8GtZ8Ak8dD6y3mZXTrdi2HDgNe5e17ZDjbih8ZOWHLwlikFYQ99AEVxcEl0F&new=1

1 H8 p2 [% @3 r& s3 I" j免责声明:如果侵犯了您的权益,请联系站长,我们会及时删除侵权内容,谢谢合作! |

本帖子中包含更多资源

您需要 登录 才可以下载或查看,没有账号?立即注册

×

|

|手机版|小黑屋|梦想之都-俊月星空

( 粤ICP备18056059号 )|网站地图

|手机版|小黑屋|梦想之都-俊月星空

( 粤ICP备18056059号 )|网站地图